Если вы получаете новости из социальных сетей, большинство американцев, вы подвергаетесь ежедневной дозе мистификаций, слухам, теориям заговора и вводящим в заблуждение новостям. Когда все это смешивается с достоверной информацией из честных источников, правда может быть очень трудно различить.

Фактически, анализ моей исследовательской группы данных из Колумбийского университета выходящий слуховой трекер предполагает, что это дезинформация настолько же вероятна, что и вирусная как надежная информация.

Многие спрашивают, является ли этот натиск цифровой дезинформации повлияли на результат выборов в 2016 США. Правда в том, что мы не знаем, хотя есть основания полагать, что это вполне возможно, основываясь на прошлый анализ и счета из других стран, Каждая часть дезинформации способствует формированию наших мнений. В целом, вред может быть очень реальным.

Являясь исследователем распространения дезинформации через социальные сети, я знаю, что ограничение способности новостных фикеров продавать рекламу, как недавно объявлено Google и Facebook, является шагом в правильном направлении. Но это не сдерживает злоупотребления, вызванные политическими мотивами.

Использование социальных сетей

Около 10 лет назад мы с коллегами эксперимент в котором мы узнали, что 72 процентов студентов колледжа доверяют ссылкам, которые, как представляется, происходят от друзей - даже до ввода личной информации для входа на фишинговые сайты. Эта широко распространенная уязвимость предложила другую форму злоумышленных манипуляций: люди также могут верить в неверную информацию, получая при нажатии на ссылку из социального контакта.

Чтобы исследовать эту идею, я создал поддельная веб-страница со случайными, сгенерированными компьютером новостями сплетни - такие вещи, как «Знаменитость Х, пойманная в постели со знаменитостью Y!» Посетители сайта, которые искали имя, заставили бы сценарий автоматически сфабриковать историю о человеке. Я включил на сайт отказ от права, заявив, что сайт содержит бессмысленный текст и составленные «факты». Я также разместил объявления на странице. В конце месяца я получил чек в почте с прибылью от рекламы. Это было мое доказательство: фальшивые новости могли заработать деньги, загрязняя Интернет ложью.

К сожалению, я не был единственным с этой идеей. Десять лет спустя у нас есть индустрия поддельных новостей и цифровая дезинформация, Сайты Clickbait производят мистификации, чтобы делать деньги от рекламы, а так называемые гиперпартийные сайты публикуют и распространяют слухи и теории заговора, чтобы влиять на общественное мнение.

Эта отрасль подкрепляется тем, как легко создавать социальные боты, поддельные учетные записи, контролируемые программным обеспечением, которые выглядят как настоящие люди и поэтому могут иметь реальное влияние. Исследования в моей лаборатория раскрыл множество примеров поддельных кампаний на низовом уровне, также называемых политический астротурфинг.

В ответ мы разработали BotOrNot инструмент для обнаружения социальных ботов. Это не идеально, но достаточно точный раскрыть кампании убеждения в Brexit и антивирусных движениях. Используя BotOrNot, наши коллеги обнаружили, что Большая часть онлайн-болтовни о выборах 2016 были созданы ботами.

Создание информационных пузырьков

Мы, люди, уязвимы для манипуляций цифровой дезинформацией благодаря сложному набору социальных, когнитивных, экономических и алгоритмических предубеждений. Некоторые из них развивались по уважительным причинам: доверительные сигналы от наших социальных кругов и отказ от информации, которая противоречит нашему опыту, хорошо нам помогли, когда наши виды адаптировались для уклонения от хищников. Но в сегодняшних сокращающихся онлайн-сетях связь с социальной сетью с теоретиком заговора на другой стороне планеты не помогает информировать мое мнение.

Копирование наших друзей и отмена подписки тех, кто придерживается другого мнения, дают нам эхокамеры так поляризованный что исследователи могут с высокой точностью сказать, являетесь ли вы либеральных или консервативных просто взглянув на ваших друзей. Структура сети плотный что любая дезинформация распространяется почти мгновенно в пределах одной группы и поэтому разделяется, что она не достигает другого.

Внутри нашего пузыря мы избирательно подвергаемся информации, согласованной с нашими убеждениями. Это идеальный сценарий максимизации взаимодействия, но вредный для развития здорового скептицизма. Уклон подтверждения заставляет нас делиться заголовком без чтения статья.

Наша лаборатория получила личный урок в этом, когда наш собственный исследовательский проект стал предметом порочная кампания дезинформации в преддверии промежуточных выборов 2014 в США. Когда мы исследовали происходящее, мы обнаружили, что поддельные новостные материалы о наших исследованиях преобладают среди пользователей Twitter в рамках одной партизанской эхо-камеры, большого и однородного сообщества политически активных пользователей. Эти люди быстро перефразировали и невосприимчивы к развенчанию информации.

Вирусная неизбежность

Наши исследования показывают, что, учитывая структуру наших социальных сетей и наше ограниченное внимание, неизбежный что некоторые мемы будут вирусными, независимо от их качества. Даже если люди склонны делиться информацией более высокого качества, сеть в целом не эффективна для различения надежной и сфабрикованной информации. Это помогает объяснить все вирусные мистификации, которые мы наблюдаем в дикой природе.

Ассоциация экономика внимания заботится обо всем остальном: если мы обратим внимание на определенную тему, будет подготовлена дополнительная информация по этой теме. Дешевле изготавливать информацию и передавать ее как факт, чтобы сообщить реальную истину. И изготовление может быть адаптировано к каждой группе: консерваторы читают, что папа одобрил Трампа, либералы читали, что он одобрил Клинтон. Он не сделал ни.

Следовать алгоритмам

Поскольку мы не можем обратить внимание на все сообщения в наших каналах, алгоритмы определяют то, что мы видим, а что нет. Алгоритмы, используемые платформами социальных сетей сегодня, предназначены для того, чтобы уделить приоритетное внимание привлечению должностей, которые мы, вероятно, будем нажимать, реагировать и делиться. Но недавний анализ обнаружил, что намеренно вводящие в заблуждение страницы получили как минимум столько онлайн-обмена и реакция как настоящие новости.

Этот алгоритмический уклон в сторону участия в истине усиливает наши социальные и познавательные уклоны. В результате, когда мы следуем ссылкам, разделяемым в социальных сетях, мы склонны посещать меньшие, более однородный набор источников, чем при проведении поиска и посещении лучших результатов.

Существующие исследования показывают, что пребывание в эхо-камере может заставить людей более доверчивый о принятии непроверенных слухов. Но нам нужно знать гораздо больше о том, как разные люди реагируют на одну мистификацию: некоторые сразу ее разделяют, другие проверяют ее сначала.

Мы моделирование социальной сети изучить этот конкурс между совместным использованием и проверкой фактов. Мы надеемся помочь распутать противоречивые данные о когда проверка фактов помогает остановить мистификации от распространения, а когда нет. Наши предварительные результаты свидетельствуют о том, что чем более изолировано сообщество верующих-мистификаторов, тем дольше сохраняется мистификация. Опять же, речь идет не только об обмане, но и о сети.

Многие люди пытаются понять что делать со всем этим, Согласно последнему замечанию Марка Цукерберга объявление, Команды Facebook тестируют потенциальные варианты. И группа студентов колледжа предложила просто общие ссылки на ярлыки как «проверено» или нет.

Некоторые решения остаются недоступными, по крайней мере на данный момент. Например, мы пока не можем преподавать системы искусственного интеллекта, как различать истину и ложь, Но мы можем сказать, что алгоритмы ранжирования дают более высокий приоритет более надежным источникам.

Изучение распространения поддельных новостей

Мы можем сделать нашу борьбу с поддельными новостями более эффективными, если мы лучше поймем, насколько распространена плохая информация. Если, например, боты несут ответственность за многие ложности, мы можем сосредоточить внимание на их обнаружении. Если, в качестве альтернативы, проблема заключается в эхо-камерах, возможно, мы могли бы разработать системы рекомендаций, которые не исключают разные взгляды.

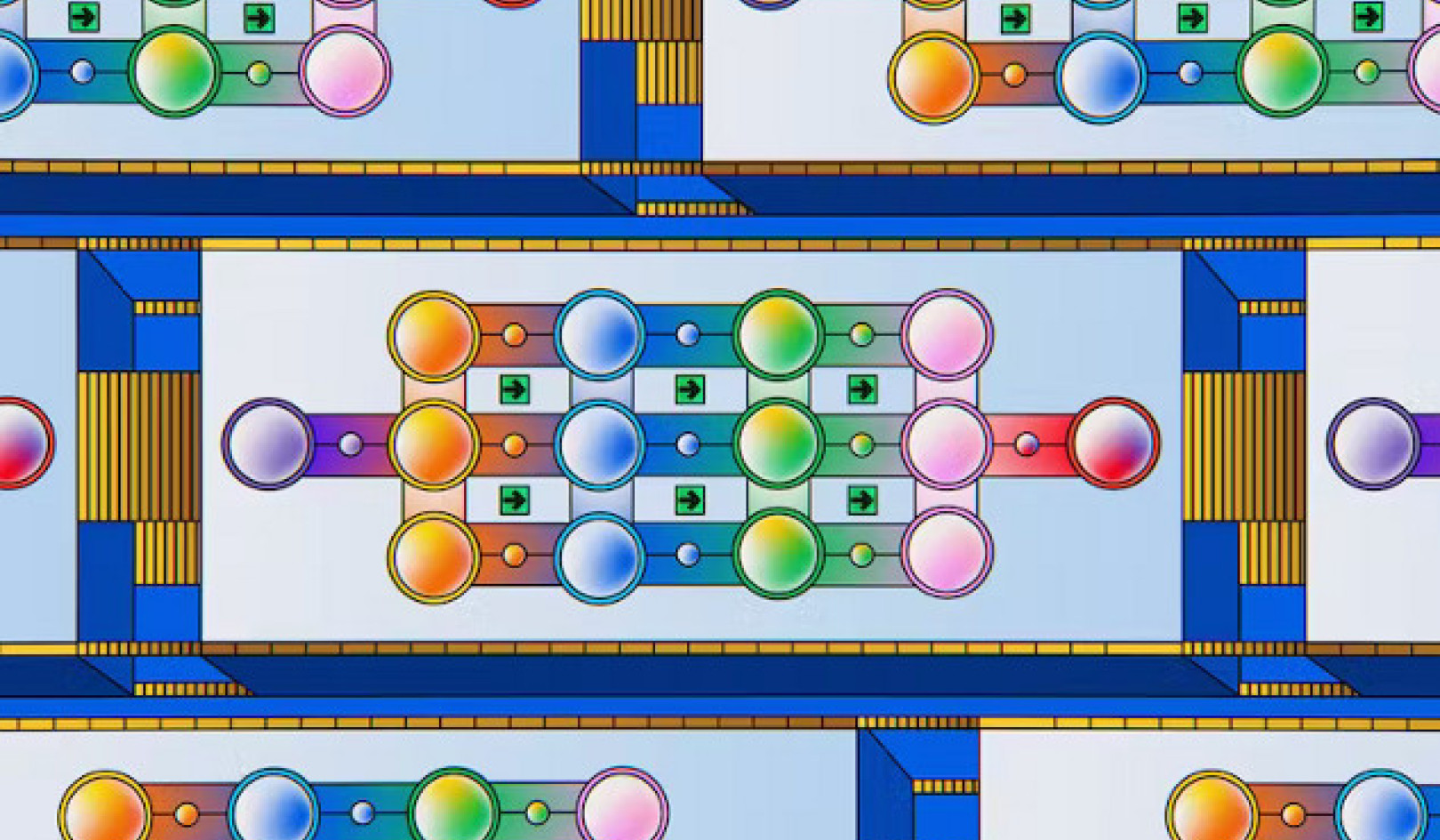

С этой целью наша лаборатория строит платформу под названием Hoaxy отслеживать и визуализировать распространение непроверенных требований и соответствующую проверку фактов в социальных сетях. Это даст нам реальные данные, с помощью которых мы можем информировать наши моделируемые социальные сети. Затем мы можем проверить возможные подходы к борьбе с фальшивыми новостями.

Hoaxy также может показать людям, насколько легко для их мнений манипулировать онлайн-информацией - и даже насколько вероятно, что некоторые из нас будут делиться ложью в Интернете. Hoaxy присоединится к набору инструментов в нашей Обсерватория по социальным медиа, который позволяет любому видеть, как мемы распространяются на Twitter. Связывание таких инструментов с человеческими фактами и платформами социальных сетей могло бы облегчить минимизацию дублирования усилий и поддержка друг друга.

Крайне важно, чтобы мы вкладывали ресурсы в изучение этого явления. Нам нужны все руки на палубе: компьютерные ученые, социологи, экономисты, журналисты и отраслевые партнеры должны работать вместе твердо стоять против распространения дезинформации.

![]()

Об авторе

Филиппо Менцер, профессор информатики и информатики; Директор Центра комплексных сетевых и системных исследований, Университет Индианы, Блумингтон

Эта статья изначально была опубликована в Беседа, Прочтите оригинал статьи.

Похожие книги:

at Внутренний рынок самовыражения и Amazon