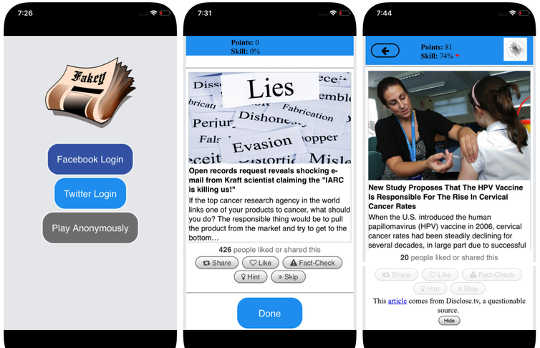

Скриншоты игры Fakey. Михай Аврам и Филиппо Менчер

Скриншоты игры Fakey. Михай Аврам и Филиппо Менчер

Социальные сети входят в число основные источники новостей в США и по всему миру. Однако пользователи подвергаются воздействию сомнительной точности, в том числе теории заговора, clickbait, гиперпартийный контент, псевдонаука и даже сфабрикованные «поддельные новости».

Неудивительно, что опубликовано так много дезинформации: спам и онлайн-мошенничество являются прибыльными для преступников, а также правительственная и политическая пропаганда как партийные, так и финансовые выгоды, Но то, что контент с низким уровнем доверия распространяется так быстро и легко предполагает, что люди и алгоритмы для социальных медиа-платформ уязвимы для манипуляций.

Наши исследования выявили три типа предвзятости, которые делают экосистему социальных сетей уязвимыми как для преднамеренной, так и для случайной дезинформации. Вот почему наши Обсерватория по социальным медиа в Университете Индианы строится инструменты чтобы помочь людям осознать эти предубеждения и защитить себя от внешних воздействий, предназначенных для их использования.

Объясняя инструменты, разработанные в Обсерватории по социальным медиа:

{youtube}https://youtu.be/BIv9054dBBI{/youtube}

Смещение в мозге

Когнитивные предубеждения возникают в том, как мозг обрабатывает информацию, которую каждый человек встречает каждый день. Мозг может иметь дело только с ограниченным количеством информации, и слишком много входящих стимулов может вызвать информационной перегрузки, Это само по себе имеет серьезные последствия для качества информации в социальных сетях. Мы обнаружили, что крутая конкуренция за ограниченное внимание пользователей означает, что некоторые идеи становятся вирусными, несмотря на их низкое качество – даже когда люди предпочитают делиться высококачественным контентом.

Чтобы избежать переполнения, мозг использует количество трюков, Эти методы обычно эффективны, но могут также стать предубеждениями когда они применяются в неправильных контекстах.

Один когнитивный ярлык происходит, когда человек решает, делиться ли история, которая появляется на их фиде в социальных сетях. Люди очень затронуты эмоциональными коннотациями заголовка, хотя это не является хорошим показателем точности статьи. Гораздо важнее кто написал пьесу.

Чтобы противостоять этому предубеждению и помочь людям уделять больше внимания источнику иска перед его совместным использованием, мы разработали Fakey, мобильная новостная грамотная игра (бесплатно на Android и iOS), имитируя типичный фид новостей для социальных сетей, в котором сочетаются новости из основных источников и источников с низким доверием. Игроки получают больше очков за обмен новостями из надежных источников и помечение подозрительного контента для проверки фактов. В этом процессе они учатся распознавать сигналы доверия к источнику, такие как заявления о гиперпартментах и эмоционально заряженные заголовки.

Склонность к обществу

Другой источник предвзятости исходит от общества. Когда люди напрямую связаны со своими сверстниками, социальные пристрастия, которые ведут их выбор друзей, влияют на информацию, которую они видят.

Фактически, в наших исследованиях мы обнаружили, что можно определить политические предпочтения пользователя Twitter просто глядя на партизанские предпочтения своих друзей. Наш анализ структуры этих партизанские сети связи найденные социальные сети особенно эффективны при распространении информации - точной или нет - когда они тесно связаны и не связаны с другими частями общества.

Тенденция к более качественной оценке информации, если она исходит из их собственных социальных кругов, создает "эхо-камеры«Которые созрели для манипуляций, сознательно или непреднамеренно. Это помогает объяснить, почему так много онлайн-разговоров переходят в «Против нас», конфронтации.

Чтобы изучить, как структура онлайн-социальных сетей делает пользователей уязвимыми для дезинформации, мы построили Hoaxy, система, которая отслеживает и визуализирует распространение контента из источников с низкой достоверностью и как он конкурирует с содержанием проверки фактов. Наш анализ данных, собранных Hoaxy во время президентских выборов в 2016 US, показывает, что учетные записи Twitter, которые делили дезинформацию, были почти полностью отрезаны от исправлений, сделанных фактами.

Когда мы развернулись на дезинформационных счетах, мы обнаружили очень плотную основную группу учетных записей, перекликающихся друг с другом почти исключительно - в том числе несколько ботов. Единственные случаи, когда организации по проверке фактов когда-либо цитировались или упоминались пользователями в дезинформированной группе, заключались в вопросе их легитимности или утверждении противоположности того, что они писали.

Смещение в машине

Третья группа смещений возникает непосредственно из алгоритмов, используемых для определения того, что люди видят в Интернете. И платформы социальных сетей, и поисковые системы используют их. Эти технологии персонализации предназначены для выбора только самого привлекательного и релевантного контента для каждого отдельного пользователя. Но при этом это может привести к усилению когнитивных и социальных предрассудков пользователей, что делает их еще более уязвимыми для манипуляций.

Например, подробный рекламные инструменты, встроенные во многие платформы социальных сетей позволить эксплуатантам дезинформации эксплуатировать уклон подтверждения by пошив сообщений к людям, которые уже склонны верить им.

Кроме того, если пользователь часто нажимает на ссылки Facebook из определенного источника новостей, Facebook будет как правило, показывают, что человек больше контента этого сайта, Это так называемый "фильтр-пузырь«Эффект может изолировать людей с разных точек зрения, усиливая подтверждение предвзятости.

Наши собственные исследования показывают, что платформы социальных сетей предоставляют пользователям менее разнообразный набор источников, чем сайты, не связанные со СМИ, такие как Википедия. Поскольку это находится на уровне всей платформы, а не одного пользователя, мы называем это смещение однородности.

Еще одним важным компонентом социальных сетей является информация, которая имеет тенденцию на платформе, в соответствии с тем, что получает наибольшее количество кликов. Мы называем это склонность к популярности, поскольку мы обнаружили, что алгоритм, предназначенный для продвижения популярного контента, может негативно повлиять на общее качество информации на платформе. Это также приводит к существующему когнитивному уклону, усиливая то, что кажется популярным независимо от его качества.

Все эти алгоритмические смещения можно манипулировать социальные боты, компьютерные программы, которые взаимодействуют с людьми через социальные сети. Большинство социальных ботов, таких как Twitter Большой Бен, безвредны. Однако некоторые скрывают свою реальную природу и используются для злонамеренных намерений, таких как повышение дезинформации или ложно создавая появление массового движения, также называемый «astroturfing». Мы обнаружили доказательства этого типа манипуляций в преддверии промежуточных выборов 2010 в США.

Чтобы изучить эти стратегии манипуляции, мы разработали инструмент для обнаружения социальных ботов, называемых Botometer, Ботометр использует машинное обучение для обнаружения ботов-счетов, путем проверки тысяч различных функций учетных записей Twitter, например, времени его сообщений, как часто он чириканье, и учетных записей, которые он следует, и ретвитов. Это не идеально, но он показал, что столько, сколько 15 процент аккаунтов Twitter показывает признаки ботов.

Используя Botometer в сочетании с Hoaxy, мы проанализировали суть сети дезинформации во время президентской кампании 2016 в США. Мы обнаружили, что многие боты используют как когнитивные, так и подтвержденные склонности своих жертв и алгоритмические предубеждения Twitter.

Эти боты способны создавать пузырьки фильтра вокруг уязвимых пользователей, подавая им ложные утверждения и дезинформацию. Во-первых, они могут привлечь внимание пользователей, которые поддерживают конкретного кандидата, читая хеттаги этого кандидата или упоминая и перенаправляя человека. Затем боты могут усиливать ложные утверждения, размазающие противников, путем перебора статей из источников с низкой достоверностью, которые соответствуют определенным ключевым словам. Эта деятельность также делает алгоритм для других пользователей ложными историями, которые широко используются.

Понимание сложных уязвимостей

Даже когда наши исследования и другие исследования показывают, как люди, учреждения и даже целые общества могут манипулировать социальными сетями, существуют много вопросов осталось ответить. Особенно важно выяснить, как эти разные пристрастия взаимодействуют друг с другом, потенциально создавая более сложные уязвимости.

Такие инструменты, как наша, предлагают интернет-пользователям больше информации об дезинформации и, следовательно, некоторой степени защиты от вреда. Решения будут вряд ли будут только технологические, хотя, вероятно, для них будут некоторые технические аспекты. Но они должны учитывать когнитивные и социальные аспекты проблемы.

Об авторах

Джованни Лука Чампалья, ассистент-исследователь, Индийский институт сетевых наук, Университет Индианы и Филиппо Менцер, профессор информатики и информатики; Директор Центра комплексных сетевых и системных исследований, Университет Индианы

Эта статья изначально была опубликована в Беседа, Прочтите оригинал статьи.

Книги по этой теме

at

Спасибо за визит InnerSelf.comгде есть 20,000+ изменяющие жизнь статьи, пропагандирующие «Новые взгляды и новые возможности». Все статьи переведены на 30 + языки. Подписаться в журнал InnerSelf Magazine, публикуемый еженедельно, и в журнал Marie T Russell's Daily Inspiration. InnerSelf Magazine издается с 1985 года.

Спасибо за визит InnerSelf.comгде есть 20,000+ изменяющие жизнь статьи, пропагандирующие «Новые взгляды и новые возможности». Все статьи переведены на 30 + языки. Подписаться в журнал InnerSelf Magazine, публикуемый еженедельно, и в журнал Marie T Russell's Daily Inspiration. InnerSelf Magazine издается с 1985 года.