Скриншоты Twitter / Unsplash, Автор условии

Twitter на выходных «пометил» как подтасованное видео, на котором кандидат в президенты США от демократов Джо Байден якобы забыл, в каком штате он находится, обращаясь к толпе.

Приветствие Байдена «Привет, Миннесота» контрастировало с заметными вывесками с надписью «Тампа, Флорида» и «Отправьте сообщение FL на номер 30330».

Проверка фактов Associated Press подтвердил знаки были добавлены в цифровом виде, и исходные кадры действительно были с митинга в Миннесоте. Но к моменту удаления вводящего в заблуждение видео у него уже было более миллиона просмотров, The Guardian. отчеты.

ЛОЖНОЕ видео, в котором утверждается, что Байден забыл, в каком состоянии он находится, было просмотрено в Твиттере более 1 миллиона раз за последние 24 часа.

- Дони О'Салливан (@donie) 1 ноября 2020

В видео Байден говорит: «Привет, Миннесота».

Событие действительно произошло в MN - на вывесках на сцене написано MN.

Но фальшивые видео отредактировали знаки, чтобы читать Флориду pic.twitter.com/LdHQVaky8v

Если вы используете социальные сети, скорее всего, вы увидите (и перейдете) некоторые из более чем 3.2 млрд штук. изображения и 720,000 часа видео делится ежедневно. Столкнувшись с таким избытком контента, как мы можем узнать, что реально, а что нет?

Хотя одной из частей решения является более широкое использование инструментов проверки контента, не менее важно, чтобы мы все повышали нашу цифровую медиаграмотность. В конце концов, одна из лучших линий защиты - и единственная, которую вы можете контролировать - это вы.

Видеть не всегда значит верить

Дезинформация (когда вы случайно делитесь ложным контентом) и дезинформация (когда вы умышленно делитесь им) на любом носителе могут подорвать доверие к гражданским институтам такие как новостные организации, коалиции и общественные движения. Однако фальшивые фото и видео часто оказываются наиболее сильными.

Для тех, у кого есть политический интерес, создание, распространение и / или редактирование ложных изображений может отвлекать, сбивать с толку и манипулировать зрителями, чтобы посеять разлад и неуверенность (особенно в уже поляризованной среде). Плакаты и платформы также могут зарабатывать деньги на распространении поддельного, сенсационного контента.

Только 11-25% журналистов во всем мире используют инструменты проверки контента социальных сетей, по данным Международного центра журналистов.

Вы могли заметить подделанное изображение?

Рассмотрим эту фотографию Мартина Лютера Кинга-младшего.

Д-р Мартин Лютер Кинг-младший показывает средний палец # DopeHistoricPics pic.twitter.com/5W38DRaLHr

- Dope Historic Pics (@dopehistoricpic) 20 декабря 2013

Эта измененное изображение клонирует часть фона над пальцем короля-младшего, так что похоже, что он выключает камеру. Он был признан подлинным на Twitter, Reddit. и сайты сторонников превосходства белых.

В оригинал Фотография 1964 года. Кинг высветил знак «V для победы» после того, как узнал, что Сенат США принял закон о гражданских правах.

«Те, кто любит мир, должны научиться организовываться так же эффективно, как и те, кто любит войну».

- Заповедник Вилли (@WilliesReserve) 21 января 2019

Д-р Мартин Лютер Кинг-младший

??

Эта фотография была сделана 19 июня 1964 года. На ней доктор Кинг подает знак мира после того, как услышал, что закон о гражданских правах был принят сенатом. @snopes pic.twitter.com/LXHmwMYZS5

Помимо добавления или удаления элементов, существует целая категория манипуляций с фотографиями, при которых изображения объединяются.

В начале этого года Фото вооруженного человека сделал фотошоп Fox News, которые накладывали человека на другие сцены без раскрытия правок, газета Seattle Times переправу.

Вы имеете в виду этого парня, которого сфотографировали на три отдельные фотографии, опубликованные Fox News? pic.twitter.com/fAXpIKu77a

— Зандер Йейтс ???????? ???? ????????? (@ZanderYates) 13 июня 2020

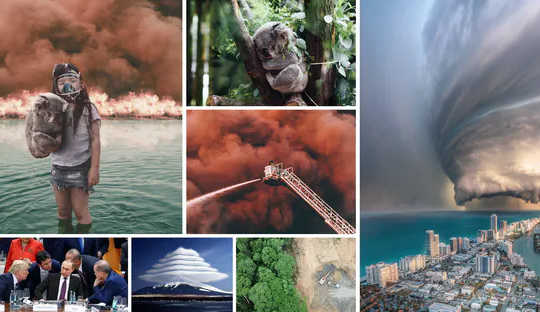

Аналогичным образом, изображение Ниже тысячи раз поделились в социальных сетях в январе, во время лесных пожаров в Австралии «Черное лето». Проверка фактов AFP подтвердил это не аутентично и на самом деле представляет собой комбинацию несколько отдельный фотографии.

Образ сильнее криков Греты. Молчаливая девушка держит в руках коалу. Она смотрит прямо на вас из вод океана, где они нашли убежище. На ней респираторная маска. Позади них стена огня. Я не знаю имени фотографа #Australia pic.twitter.com/CrTX3lltdh

- Музыка EVC (@EVCMusicUK) 6 января 2020

Полностью или частично синтетический контент

В Интернете вы также найдете сложные "deepfake»Видеоролики, на которых (обычно известные) люди говорят или делают то, чего никогда не делали. Менее продвинутые версии могут быть созданы с помощью приложений такие как Zao и Рефейс.

{vembed Y = yaq4sWFvnAY}

Команда из Массачусетского технологического института создала это фальшивое видео, на котором президент США Ричард Никсон зачитывает строки из речи, написанной на случай неудачной высадки на Луну в 1969 году. (YouTube)

Или, если вы не хотите использовать свою фотографию для изображения профиля, вы можете по умолчанию использовать одно из нескольких веб-сайты предлагая сотни тысяч фотореалистичных изображений людей, созданных с помощью искусственного интеллекта.

Этих людей не существует, это просто изображения, созданные искусственным интеллектом. Созданные фотографии, CC BY

Редактирование значений пикселей и (не очень) простая обрезка

Обрезка также может сильно изменить контекст фотографии.

Мы видели это в 2017 году, когда правительственный служащий США редактировал официальные фотографии инаугурации Дональда Трампа, чтобы толпа казалась больше, по словам The Guardian. . Сотрудник вырезал пустое место «там, где кончалась толпа» для набора фотографий для Трампа.

Мнения толпы на инаугурации бывшего президента США Барака Обамы в 2009 году (слева) и президента Дональда Трампа в 2017 году (справа). AP

Мнения толпы на инаугурации бывшего президента США Барака Обамы в 2009 году (слева) и президента Дональда Трампа в 2017 году (справа). AP

Но как насчет правок, которые изменяют только значения пикселей, такие как цвет, насыщенность или контраст?

Один исторический пример иллюстрирует последствия этого. В 1994 г. журнал Time чехол для варгана О. Дж. Симпсона значительно «затемнил» Симпсона в его полицейский снимок. Это подлило масла в огонь уже охваченного расовой напряженностью дела, к которому журнал ответ:

Ни Время, ни художник не предполагали никакого расового подтекста.

Возможно, вы думаете об этом противоречии с 1994 года. Журнал Time попал в кучу неприятностей из-за того, что затемнил фотографию О. Джей Симпсона, и в итоге вынужден был отказаться от этого вопроса. Это, наверное, самый известный пример чего-то подобного. И да, я встречаюсь с самим собой, я знаю. pic.twitter.com/7U7Yw7XZGU

- Пилар Педраса ТВ (@PilarPedrazaTV) 2 ноября 2020

Инструменты для разоблачения цифровых фейков

Для тех из нас, кто не хочет быть обманутым визуальной дезинформацией, доступны инструменты, хотя каждый имеет свои ограничения (что мы обсуждаем в нашем недавнем бумаги).

Невидимый цифровой водяной знак был предложен в качестве решения. Однако это не так широко распространено и требует поддержки как издателей, так и распространителей контента.

Обратный поиск изображений (например, Google) часто бесплатен и может быть полезен для идентификации более ранних, потенциально более аутентичных копий изображений в Интернете. Тем не менее, это не надежно, потому что:

- полагается на неотредактированные копии СМИ, уже находящихся в сети

- не ищет весь Web

- не всегда позволяет фильтровать по времени публикации. Некоторые службы обратного поиска изображений, такие как TinEye поддерживают эту функцию, а Google - нет.

- возвращает только точные совпадения или почти совпадения, поэтому он не является полным. Например, редактирование изображения с последующим изменением его ориентации может обмануть Google, заставив его подумать, что это совершенно другое изображение.

Самые надежные инструменты сложны

Между тем, ручные методы судебно-медицинской экспертизы для визуальной дезинформации сосредоточены в основном на редактировании, видимом невооруженным глазом, или полагаются на изучение функций, которые не включены в каждое изображение (например, тени). Кроме того, они трудоемки, дороги и требуют специальных знаний.

Тем не менее, вы можете получить доступ к работе в этой области, посетив такие сайты, как Snopes.com, на котором есть постоянно растущий репозиторий «подделка».

Компьютерное зрение и машинное обучение также предлагают относительно продвинутые возможности обнаружения изображений и видео. Но они тоже требуют технических знаний, чтобы работать и понимать.

Более того, их улучшение требует использования больших объемов «обучающих данных», но репозитории изображений, используемые для этого, обычно не содержат реальных изображений, которые можно увидеть в новостях.

Если вы используете инструмент проверки изображений, такой как проект REVEAL помощник проверки изображений, вам может понадобиться эксперт для интерпретации результатов.

Однако хорошая новость заключается в том, что перед тем, как обратиться к любому из вышеперечисленных инструментов, вы можете задать себе несколько простых вопросов, чтобы потенциально выяснить, является ли фотография или видео в социальных сетях подделкой. Думать:

- изначально он был создан для социальных сетей?

- насколько широко и как долго он был распространен?

- какие отзывы он получил?

- кто была предполагаемая аудитория?

Довольно часто логических выводов, сделанных из ответов, бывает достаточно, чтобы отсеять неаутентичные визуальные эффекты. Вы можете получить доступ к полному списку вопросов, составленному экспертами Manchester Metropolitan University, здесь.![]()

Об авторах

Т.Дж. Томсон, старший преподаватель визуальной коммуникации и медиа, Технологический университет Квинсленда; Дэниел Ангус, доцент кафедры цифровых коммуникаций, Технологический университет Квинслендаи Пола Дутсон, старший преподаватель, Технологический университет Квинсленда

Эта статья переиздана из Беседа под лицензией Creative Commons. Прочтите оригинал статьи.