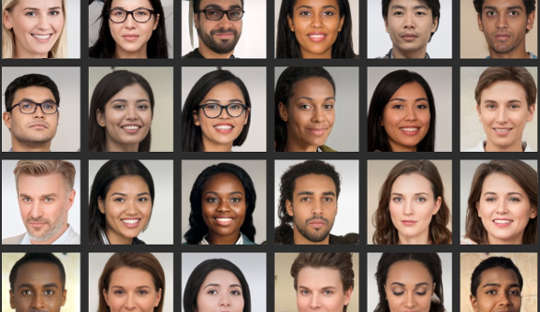

Даже если вы думаете, что умеете анализировать лица, , согласно исследованиям, многие люди не могут надежно отличить фотографии реальных лиц от изображений, созданных компьютером. Это особенно проблематично сейчас, когда компьютерные системы могут создавать реалистичные фотографии людей, которых не существует.

Недавно фальшивый профиль LinkedIn с изображением профиля, сгенерированным компьютером, попал в новости, потому что он успешно связаны с официальными лицами США и другими влиятельными лицами на сетевой платформе, например. Специалисты контрразведки даже говорят, что шпионы регулярно создают фантомные профили с такими фотографиями, чтобы нацеливаться на иностранные цели через социальные сети.

Эти глубокие фейки становятся широко распространенными в повседневной культуре, а это означает, что люди должны лучше знать, как они используются в маркетинге, рекламе и социальных сетях. Изображения также используются в злонамеренных целях, таких как политическая пропаганда, шпионаж и информационная война.

Для их создания используется так называемая глубокая нейронная сеть, компьютерная система, которая имитирует способ обучения мозга. Это «обучается», подвергая его воздействию все более крупных наборов данных реальных лиц.

По сути, две глубокие нейронные сети настроены друг против друга, соревнуясь в создании наиболее реалистичных изображений. В результате конечные продукты называются образами GAN, где GAN означает Generative Adversarial Networks. Процесс генерирует новые изображения, которые статистически неотличимы от обучающих изображений.

В нашем исследовании, опубликованном в iScience, мы показали, что неспособность отличить эти искусственные лица от настоящих влияет на наше поведение в Интернете. Наше исследование показывает, что поддельные изображения могут подорвать наше доверие к другим людям и коренным образом изменить то, как мы общаемся в Интернете.

Мои коллеги и я обнаружили, что люди воспринимали лица GAN как более реалистичные, чем настоящие фотографии лиц реальных людей. Хотя пока неясно, почему это так, этот вывод действительно выделить последние достижения в технологии используется для создания искусственных изображений.

И мы также обнаружили интересную связь с привлекательностью: лица, которые были оценены как менее привлекательные, также были оценены как более реальные. Менее привлекательные лица могут считаться более типичными и типичное лицо может быть использовано в качестве эталона по которому оцениваются все грани. Следовательно, эти лица GAN будут выглядеть более реальными, потому что они больше похожи на ментальные шаблоны, которые люди построили из повседневной жизни.

Но восприятие этих искусственных лиц как подлинных может также иметь последствия для общего уровня доверия, которое мы распространяем на круг незнакомых людей — понятие, известное как «социальное доверие».

Мы часто слишком много читаем в лицах, которые видим, и первое впечатление, которое мы формируем, определяет наши социальные взаимодействия. Во втором эксперименте, который стал частью нашего последнего исследования, мы увидели, что люди с большей вероятностью доверяют информации, передаваемой лицами, которые они ранее считали реальными, даже если они были созданы искусственно.

Неудивительно, что люди больше доверяют лицам, которые они считают реальными. Но мы обнаружили, что доверие было подорвано, как только люди были проинформированы о потенциальном присутствии искусственных лиц в онлайн-взаимодействии. Затем они показали более низкий уровень доверия в целом — независимо от того, были ли лица настоящими или нет.

Этот результат можно считать в некотором смысле полезным, потому что он сделал людей более подозрительными в среде, где могут действовать поддельные пользователи. Однако, с другой точки зрения, это может постепенно подорвать саму природу нашего общения.

Как правило, мы оперируем предположение по умолчанию, что другие люди в основном правдивы и заслуживают доверия. Рост количества поддельных профилей и другого искусственного онлайн-контента поднимает вопрос о том, насколько их присутствие и наши знания о них могут изменить это состояние «правды по умолчанию», что в конечном итоге подорвет социальное доверие.

Изменение наших значений по умолчанию

Переход к миру, в котором реальное неотличимо от нереального, может также сместить культурный ландшафт с преимущественно правдивого на преимущественно искусственный и обманчивый.

Если мы регулярно подвергаем сомнению правдивость того, что мы видим в сети, это может потребовать от нас перенаправить наши умственные усилия с обработки самих сообщений на обработку личности мессенджера. Другими словами, широкое использование очень реалистичного, но искусственного онлайн-контента может заставить нас думать по-другому — так, как мы этого не ожидали.

В психологии мы используем термин «мониторинг реальности» для того, чтобы правильно определить, исходит ли что-то из внешнего мира или из нашего мозга. Развитие технологий, которые могут создавать поддельные, но очень реалистичные лица, изображения и видеозвонки, означает, что мониторинг реальности должен основываться на информации, отличной от наших собственных суждений. Это также призывает к более широкому обсуждению того, может ли человечество все еще позволить себе игнорировать истину по умолчанию.

Крайне важно, чтобы люди были более критичны при оценке цифровых лиц. Это может включать использование обратного поиска изображений для проверки подлинности фотографий, осторожность в отношении профилей в социальных сетях с небольшим количеством личной информации или большим количеством подписчиков, а также осведомленность о возможности использования технологии дипфейков в гнусных целях.

Следующим рубежом в этой области должны стать улучшенные алгоритмы обнаружения поддельных цифровых лиц. Затем они могут быть встроены в платформы социальных сетей, чтобы помочь нам отличить настоящее от подделки, когда дело доходит до лиц новых знакомых.

Об авторе

Манос Цакирис, профессор психологии, директор Центра политики чувств, Королевский Холлоуэй Лондонского университета

Эта статья переиздана из Беседа под лицензией Creative Commons. Прочтите оригинал статьи.